¿Qué es un deepfake? Todo lo que necesitas saber sobre los medios falsos impulsados por IA.

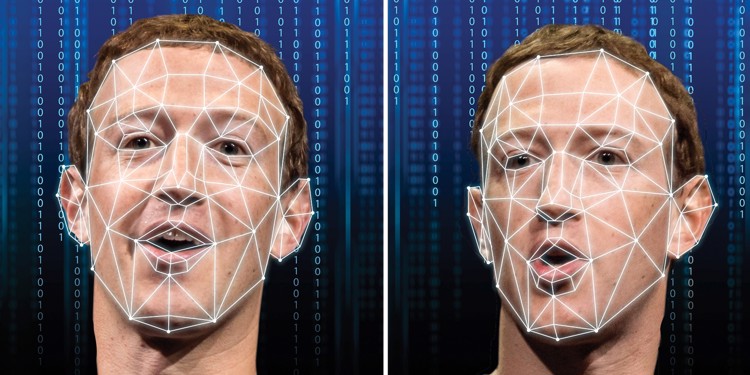

Recientemente, la tecnología deepfake ha estado en los titulares. La última repetición en imágenes de computadora, las falsificaciones profundas se crean cuando se programa la inteligencia artificial (IA) para reemplazar la semejanza de una persona con otra en un video grabado.

Las computadoras han mejorado cada vez más en la simulación de la realidad. El cine moderno, por ejemplo, se basa en gran medida en decorados, escenarios y personajes generados por computadora en lugar de ubicaciones prácticas y accesorios que alguna vez fueron comunes. La mayoría de las veces estas escenas son en gran medida indistinguibles de la realidad.

¿Qué es un deepfake y cómo funciona?

El término "deepfake" proviene de la tecnología subyacente "deep learning", que es una forma de IA. Los algoritmos de aprendizaje profundo, que se enseñan a sí mismos a resolver problemas cuando se les dan grandes conjuntos de datos, se utilizan para intercambiar caras en videos y contenido digital para crear medios falsos de apariencia realista.

Existen varios métodos para crear deepfakes, pero el más común se basa en el uso de redes neuronales profundas que involucran codificadores automáticos que emplean una técnica de intercambio de caras. Primero se necesita un video de destino para usar como base del deepfake y luego una colección de videoclips de la persona que desea insertar en el destino.

Los videos pueden no tener ninguna relación; el destino puede ser un clip de una película de Hollywood, por ejemplo, y los videos de la persona que desea insertar en la película pueden ser clips aleatorios descargados de YouTube.

El codificador automático es un programa de inteligencia artificial de aprendizaje profundo que tiene la tarea de estudiar los videoclips para comprender cómo se ve la persona desde una variedad de ángulos y condiciones ambientales, y luego mapear a esa persona con el individuo en el video de destino al encontrar características comunes.

Se agrega otro tipo de aprendizaje automático a la mezcla, conocido como Redes Adversarias Generativas (GAN), que detecta y mejora cualquier falla en el deepfake dentro de múltiples rondas, lo que dificulta que los detectores de deepfake los decodifiquen.

Las GAN también se utilizan como un método popular para la creación de deepfakes, basándose en el estudio de grandes cantidades de datos para "aprender" cómo desarrollar nuevos ejemplos que imiten lo real, con resultados dolorosamente precisos.

Varias aplicaciones y softwares facilitan la generación de deepfakes incluso para principiantes, como la aplicación china Zao, DeepFace Lab, FaceApp (que es una aplicación de edición de fotos con técnicas de inteligencia artificial integradas), Face Swap y DeepNude. Esta última se eliminó hace tiempo, al ser una aplicación particularmente peligrosa que generaba imágenes de desnudos falsos de mujeres.

Se puede encontrar una gran cantidad de softwares deepfake en GitHub, una comunidad de código abierto de desarrollo de software. Algunas de estas aplicaciones se utilizan con fines de entretenimiento puro, razón por la cual la creación de deepfake no está prohibida, mientras que es mucho más probable que otras se utilicen de forma maliciosa.

Muchos expertos creen que, en el futuro, los deepfakes se volverán mucho más sofisticados a medida que la tecnología se desarrolle más y podrían presentar amenazas más serias para el público, relacionadas con la interferencia electoral, la tensión política y la actividad criminal.

¿Cómo se utilizan los deepfakes?

Si bien la capacidad de intercambiar rostros automáticamente para crear videos sintéticos creíbles y de apariencia realista tiene algunas aplicaciones benignas interesantes (como en el cine y los juegos), esta es obviamente una tecnología peligrosa con algunas aplicaciones preocupantes. Una de las primeras aplicaciones del mundo real para deepfakes fue, de hecho, crear pornografía sintética.

En 2017, un usuario de reddit llamado "deepfakes" creó un foro de pornografía en el que aparecían actores con caras cambiadas. Desde entonces, la pornografía (especialmente la pornografía de venganza) ha sido noticia repetidamente, dañando gravemente la reputación de celebridades y figuras destacadas. Según un informe de Deeptrace, la pornografía representó el 96% de los videos deepfake encontrados en línea en 2019.

El video deepfake también se ha utilizado en política. En 2018, por ejemplo, un partido político belga publicó un video de Donald Trump dando un discurso en el que pedía a Bélgica que se retirara del acuerdo climático de París. Sin embargo, Trump nunca pronunció ese discurso: fue una farsa. Ese no fue el primer uso de un deepfake para crear videos engañosos, y los expertos políticos conocedores de la tecnología se están preparando para una futura ola de noticias falsas que presentará deepfakes convincentemente realistas.

Por supuesto, no todos los videos deepfake representan una amenaza existencial para la democracia. No hay escasez de deepfakes que se utilizan para el humor y la sátira, como chips que responden preguntas como ¿cómo se vería Nicolas Cage si apareciera en "En busca del arca perdida"?

¿Los deepfakes son solo videos?

Los deepfakes no se limitan solo a videos. El audio deepfake es un campo en rápido crecimiento que tiene una enorme cantidad de aplicaciones.

Ahora se pueden hacer deepfakes de audio realistas utilizando algoritmos de aprendizaje profundo con solo unas pocas horas (o en algunos casos, minutos) de audio de la persona cuya voz se está clonando, y una vez que se crea un modelo de voz, esa persona puede decir algo, como cuando se utilizó un audio falso de un CEO para cometer fraude el año pasado.

El audio Deepfake tiene aplicaciones médicas en forma de reemplazo de voz, así como en el diseño de juegos de computadora; ahora los programadores pueden permitir que los personajes de los jugadores digan cualquier cosa en tiempo real en lugar de depender de un conjunto limitado de guiones que se grabaron antes de que el juego fuera publicado.

¿Cómo detectar un deepfake?

A medida que los deepfakes se vuelven más comunes, la sociedad, en conjunto, probablemente tendrá que adaptarse para detectar videos deepfake de la misma manera que los usuarios en línea ahora están sintonizados para detectar otros tipos de noticias falsas.

A menudo, como es el caso de la ciberseguridad, debe surgir una tecnología más deepfake para detectarla y evitar que se propague, lo que a su vez puede desencadenar un círculo vicioso y potencialmente crear más daño.

Hay un puñado de indicadores que revelan deepfakes:

Los deepfakes actuales tienen problemas para animar caras de manera realista, y el resultado es un video en el que el sujeto nunca parpadea, o parpadea con demasiada frecuencia o de forma poco natural. Sin embargo, después de que investigadores de la Universidad de Albany publicaran un estudio que detectaba la anomalía del parpadeo, se lanzaron nuevos deepfakes que ya no tenían este problema.

Busque problemas con la piel o el cabello, o rostros que parezcan más borrosos que el entorno en el que están colocados. El enfoque puede parecer anormalmente suave.

¿La iluminación parece poco natural? A menudo, los algoritmos deepfake conservarán la iluminación de los clips que se utilizaron como modelos para el vídeo falso, que no coincide con la iluminación del vídeo objetivo.

Es posible que el audio no parezca coincidir con la persona, especialmente si el video fue falso, pero el audio original no fue manipulado con tanto cuidado.

Combatir los deepfakes con tecnología

Si bien los deepfakes solo se volverán más realistas con el tiempo a medida que mejoren las técnicas, no estamos del todo indefensos cuando se trata de combatirlos. Varias empresas están desarrollando métodos para detectar deepfakes y varias de ellas son startups.

Sensity, por ejemplo, ha desarrollado una plataforma de detección similar a un antivirus para deepfakes que alerta a los usuarios por correo electrónico cuando ven algo que tiene huellas dactilares reveladoras de medios sintéticos generados por IA. Sensity utiliza los mismos procesos de aprendizaje profundo que se utilizan para crear videos falsos.

Operation Minerva adopta un enfoque más sencillo para detectar deepfakes. El algoritmo de esta compañía compara los posibles deepfakes con videos conocidos que ya han sido "digitalizados". Por ejemplo, puede detectar ejemplos de pornografía de venganza al reconocer que el video deepfake es simplemente una versión modificada de un video existente que Operation Minerva ya ha catalogado.

El año pasado, Facebook organizó el Deepfake Detection Challenge, una iniciativa abierta y colaborativa para fomentar la creación de nuevas tecnologías para detectar deepfakes y otros tipos de medios manipulados. La competencia contó con premios de hasta $500,000 dólares.